Para ésta semana continuamos con los temas de lecturas científicas, ahora el tema es referente a ahorro de energía, el documento seleccionado fue:

...

An Energy-Efficient MAC Protocol with Random

Listen-Sleep Schedule for Wireless Sensor Networks

Sung-Chan Choi∗ , Jang-Won Lee∗ , Yeonsoo Kim† , Hakjin Chong†

∗ Dept. of Electrical and Electronic Engineering, Yonsei University, Seoul, Korea

† Future Technology Laboratory, KT, Seoul, Korea

...

Resumen

En el paper, se prope un protocolo MAC que hace uso eficiente de la energía para redes de sensores inalámbricos. Puesto que los nodos sensores utilizan energía de una batería, reducir el consumo de energía es un tema crítico para prolongar la vida útil de la red.

Para resolver este problema, se utiliza un ciclo de escucha-espera conocido como S-MAC, lo que permite a los nodos apagar su transceptor durante un período de espera. En S-MAC, los nodos sensores tienen un ciclo fijo de actividad y un calendario sincronizado en un clúster virtual. Por lo tanto, en la S-MAC, no es fácil adaptar una variación del entorno de red. Por otra parte, debido a la programación sincronizada, las colisiones de transmisión aumentarán resultando en el desperdicio de energía y de bajo rendimiento. Para hacer frente a tales ineficiencias en S-MAC, se propone un sensor de probabilidad MAC (PS-MAC), en el que cada nodo determina su estado, "escuchar" o "sueño", basado pseudo-aleatoriamente en su propia probabilidad de activación previa y las probabilidades de pre-wakeup de su nodos vecinos en cada intervalo de tiempo. Esto permite que el programa de escucha-dormir mantega cada par transmisor-receptor sincronizado mientras que el del resto de los nodos puede ser asincrónico. Por lo tanto, las colisiones pueden reducirse incluso bajo condiciones de tráfico pesado que resultan en la reducción de desperdicio de energía y el logro de un alto rendimiento. Además, ya que la probabilidad de pre-activación de cada nodo se puede ajustar la adaptación al cambio del entorno de red, mediante el ajuste de forma dinámica probabilidades pre-wakeup de nodos de sensores, el rendimiento del sistema puede ser mejorado aún más.

Introducción

Las redes de sensores inalámbricos tienen diversas aplicaciones, tales como el monitoreo del clima, animales o plantas, el seguimiento de objetivos en campo de batalla, y los edificios o infraestructuras de observación para la defensa. En general, los nodos sensores se hacen funcionar con una pequeña

batería que tiene una cantidad limitada de energía y que no puede ser fácilmente recargada o reemplazada. Por lo tanto, en el sensor inalámbrico redes, reducir el consumo de energía de cada nodo sensor es una de las cuestiones importantes para prolongar la vida de la red.

En un nodo sensor, el consumo de energía se produce en el transceptor cuya utilización está controlada un protocolo de control (MAC).

En la capa MAC, hay varias fuentes principales de desperdicio de energía. La primera de ellas es la escucha ociosa, lo que ocurre cuando un nodo se convierte en el receptor a pesar de que no hay datos para transmitir o recibir. Se ha estudiado que el consumo de energía durante el estado inactivo de escucha es comparable al consumo durante el estado de recepción. La segunda

uno está oyendo, que se produce cuando un nodo recibe y decodifica los paquetes que no estén destinados a la misma. El tercero es una overemitting, que se produce cuando el nodo transmisor transmite un paquete, mientras que el nodo receptor no está preparado para recibir. la última fuente importante de desperdicio de energía es de colisión, que se produce cuando hay transmisiones simultáneas de varios nodos que están dentro del alcance de la interferencia del nodo receptor.

Para reducir los desperdicios de energía, se propondrán algunos protocolos MAC para redes de sensores inalámbricos.

Estos protocolos se pueden clasificar como:

- Los protocolos basados en programación suelen utilizar protocolos TDMA, en el que cada nodo sensor se le asigna uno de los intervalos de tiempo y se puede comunicar sólo en el intervalo de tiempo asignado. Protocolos basados en TDMA son libres de contención, y por lo tanto, no hay desperdicio de energía causada por colisiones. Sin embargo, generalmente no es fácil diseñar un sencillo algoritmo para la asignación de ranura de tiempo, debido a un gran número de nodos sensores y la falta de la unidad central. Además, se requiere sincronización de tiempo elaborada para corregir temporización error causado por la deriva del reloj.

- Los protocolos basados en contención no son libres de colisiones. Sin embargo, debido a su simplicidad y escalabilidad, se prefieren en la práctica. Hasta el momento, muchos de estos protocolos tienen como objetivo reducir el consumo de energía. S-MAC es uno de los protocolos MAC mejor conocidos por su eficiencia energética en redes de sensores inalámbricos. Adopta una ciclo periodico de escucha-espera para reducir el tiempo de escucha ociosa. Cada nodo apaga su transceptor de radio en un período de espera. Despierta en un período de escucha y puede comunicarse con otros nodos. Este período de escucha se utiliza para el intercambio de paquetes de control tales como SYNC, RTS, CTS y ACK y paquetes de datos. Por otra parte, puesto que cada nodo tiene un ciclo de trabajo fijo, S-MAC no puede adaptarse a la variación de los entorno de red.

Se propone un nuevo protocolo MAC con el concepto de 'escuchar' y 'esperar' para reducir el plazo escucha ociosa. Sin embargo, en contraste con la técnica de sincronizado y la técnica de escucha-espera de otros protocolos, en la propuesta los periodos de escuchar y esperar están determinados pseudoaleatoriamente en las probabilidades de pre-wakeup. Esto permite que el protocolo MAC propuesto operar en un modo asíncrono entre los diferentes pares de transmisor y receptor de nodos. Esto da como resultado un trafico uniformemente distribuido a través de intervalos de tiempo y la reducción de las colisiones.

2. Diseño propuesto

El protocolo MAC propuesto se conoce como "Sensor de Probabilidad MAC (PS-MAC).

PS-MAC es un protocolo de tiempo segmentado como S-MAC. Sin embargo, a diferencia de S-MAC, en el que todos los nodos tienen ciclos de escucha sincronizados y periódicos, y el mismo ciclo de espera, en el protocolo propuesto los pares de nodos transmisor y el receptor tienen ciclos escucha asíncronos y no periódicos y horarios de espera.

Para decidir entre escuchar o esperar en cada segmento de tiempo, cada nodo sensor hace uso de un generador de números pseudoaleatorios y determina su decisión según su probabilidad de preactivación y el número de semillas. Aunque cada nodo sensor determine de manera autónoma su periodo de escucha-espera, los nodos no pueden conocer el de nodos vecinos y podría haber un problema de overemitting que es causada por la la transmisión de paquetes cuando el nodo receptor está todavía en la

modo de suspensión. Para hacer frente a esta situación, los nodos vecinos intercambian sus probabilidades de preactivación y números de semillas. esto permite a cada nodo de saber la programación nodos vecinos, que se llama "programa de pre-activación", ya que en generador pseudo-aleatorio la secuencia generada es una secuencia determinista que depende del número de semillas. Basándose en su propio programa de pre-activacion y en el de sus vecinos, cada nodo determina su tiempo de escucha real y su tiempo de espera por la elección de un intervalo de tiempo como un modo de escucha si tanto algunos de sus nodos vecinos y sí está en el modo de escucha en ese intervalo de tiempo.

Algoritmo

1. Programa de preactivación

El algoritmo consta de dos etapas:

- Determinación del programa de preactivación

- Determinación de programa de activación real.

Cada nodo i tiene su propio número de semillas Seedi que se utiliza para generar una secuencia de números pseudo-aleatorios y probabilidad de preactivacion Pi. Cada nodo determina su programa de preactivación en función de su número de semillas y la probabilidad preactivación.

En primer lugar, en cada intervalo de tiempo t, cada nodo i genera un número Ui(t) entre 0 y 1 mediante con el uso de su generador pseudo-aleatorio y su número de semillas. El nodo i establece la variable P Li (t) para el intervalo de tiempo t como:

$$

P L_{i} \left ( t \right ) = \begin{cases}

& 1 \text{ if } U_{i} \left ( t \right ) \leq P_{i} \\

& 0 \text{ otherwise }

\end{cases}

$$

Basandose en P Li (t), el nodo i determina su programa de preactivación.

Si P Li (t) = 1, el nodo i permanece en el modo de escucha en el intervalo de tiempo t , y si P Li (t) = 0, el nodo i permanece en el modo de suspensión en el intervalo de tiempo

t.

La figura 1 ilustra

un ejemplo de programación de pre-activación de dos nodos diferentes,

el nodo 1 y el nodo 2; ambos tienen la misma probabilidad de pre-activación P1 = P2 = 0.3. Cada número en cada intervalo de tiempo representa un número generado pseudoaleatoriamente según el número de semillas de cada nodo. Desde que el programa de preactivación de cada nodo se determina (pseudo)

al azar, cada nodo tiene un horario preactivación asincrónica

en PS-MAC.

Después de determinar su programa de preactivación, cada nodo determina su programa de activación real basado en su propio horario preactivación y el de sus vecinos. Cada nodo i determina Lij (t) para cada nodo j su vecino en el intervalo de tiempo t comparando su horario preactivación y el de preactivación del nodo j de la siguiente manera:

$$

L_{ij} \left ( t \right ) = \begin{cases}

& 1 \text{ if } P L_{i} \left ( t \right ) = P L_{j} \left ( t \right ) \\

& 0 \text{ otherwise }

\end{cases}

$$

Por lo tanto, si Lij (t) = 1, entonces el nodo i y el nodo j se encuentran en modo escucha en sus programas de pre-activacion. Por lo tanto, el nodo i y el nodo j son capaces de comunicarse entre sí en el intervalo de tiempo t si Lij (t) = 1. Por lo tanto, en el programa de activación real, el nodo i esta en modo de escucha, si Lij (t) = 1 para alguno de sus vecinos nodo j.

2. Programa de activación real

El programa de activación de nodo i se determina mediante la realización de este procedimiento para cada uno de sus nodos vecinos. La figura 2 muestra programación de activación real entre el nodo 1 y el nodo 2. En la figura 1, el nodo 1 está en el modo de escucha en intervalos de tiempo de 1, 4,

y 9, y el nodo 2 en las ranuras de tiempo 4, 9, y 10. Por lo tanto, los nodos 1 y 2 estan en el modo de escucha en intervalos de tiempo de 4 y 9 en su programas de activación reales y se pueden comunicar uno con el otro en aquellos intervalos de tiempo.

3. Evaluación del desempeño

3. Topología de la simulación

Se utiliza el simulador NS-2 para las pruebas. Suponemos que la PS-MAC tiene formación SYNC-RTS-CTS como en S-MAC y que el número de semillas y la probabilidad de activación de cada nodo se transmite al vecino los nodos a través de un paquete SYNC. En esta simulación, 15 nodos están desplegados en un círculo regularmente, como se ilustra en la figura. 4. el nodo receptor está situado en el centro de un círculo cuyo radio es 50 metro. Cada nodo en la línea de un círculo transmite paquetes a el nodo receptor. El tiempo de ejecución de la simulación es de 1000 segundos.

Cada nodo sensor en la red experimental tiene un nivel inicial de energía de 100 joules. Un nodo consume una potencia de 500 mW en la transmisión de paquetes, 300 mW en la recepción y de 50 MW en el estado de reposo. Los parámetros del sistema son:

| Transmit Power | 0.5 W |

|---|---|

| Receive Power | 0.3 W |

| Idle Power | 0.05 W |

| Radio Transmission Range | 250 m |

| Radio Interference Range | 550 m |

| Packet Length | 50 bytes |

Para el modelo de tráfico, se utiliza tráfico UDP / CBR. La probabilidad de preactivación de cada nodo PS-MAC se ajusta para que sea 0.3.

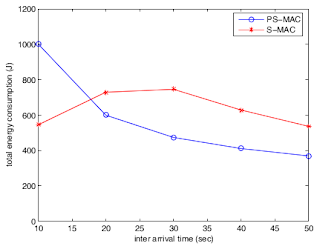

4. Consumo de energía total de S-MAC y PS-MAC

La figura 4 muestra el consumo total de energía en comparación con el paquetetiempo entre llegadas. Como se muestra en esta figura, cuando el intervalo de tiempo de llegada es más de 20 segundos, PS-MAC está consumiendo menos energía quee S-MAC. Sin embargo, cuando el tiempo entre llegadas es

menos de 20 segundos, PS-MAC consume más energía que la S-MAC. Esto se debe a una situación de carga de tráfico pesado, el cual resulta en colisiones de paquetes graves en S-MAC. Cuando una colisiónse produce en S-MAC, el nodo emisor realiza al azar un retroceso y regenera el paquete RTS. Sólo después de que el nodo emisor recibe una respuesta de paquete CTS desde el nodo receptor, se transmiten los paquetes. Sin embargo, si aumentan las colisiones, es más probable que los paquetes RTS sólo se transmiten en lugar de la secuencia completa RTS-CTS-DATA-ACK. Por lo tanto, el número de paquetes transmitidos disminuye y S-MAC tiene menos energía el consumo.

5. Proporción de entrega de paquetes de S-MAC y PS-MAC

Por otra parte, cuando el tiempo entre llegadas es inferior a 30 segundos, PS-MAC es mucho mejor que el S-MAC. Esto sucede debido al programa de sincronización en S-MAC, lo que resulta en una gran número de colisiones en situaciones de carga de tráfico pesado. Sin embargo, en PS-MAC, debido a la programación asíncrona los tiempos de escucha-espera entre cada par de nodos, el número de colisiones disminuye proporcionando una relación de entrega de paquetes más alta.

6. Eficiencia energética de PS-MAC relativa a S-MAC

La figura 6 muestra la eficiencia energética de PS-MAC relativa a S-MAC. Se muestra el consumo de energía por paquete transmitido con éxito para cada protocolo. Como se muestra en esta figura, PS-MAC tiene mejor rendimiento que el S-MAC. Por otra parte, como el tráfico cargas se vuelven más pesados, PS-MAC proporciona una mayor eficiencia energética que S-MAC. Este resultado nos dice que en S-MAC, el desperdicio de energía es mucho más grande en situaciones de carga más pesadas debido a la mucho mayor número de colisiones en comparación con PS-MAC.

Conclusión

Como se puede ver en los experimentos, me parece que el método propuesto es bastante bueno, ya que, establecer periodos donde los nodos permanecen activos y después entran en espera o dormidos parece ser una solución bastante simple y lógica, que mejor forma de ahorrar energía que apagar los nodos cuando no están haciendo nada.

Como ya puede leer, el único detalle es el establecimiento de dichos intervalos de escucha-espera, ya que se hace de forma pseudoaleatoria, pienso que en este aspecto aún se puede mejorar más. Es de esperarse que en condiciones de tráfico pesado el modelo propuesto se comporte un poco peor, pues los periodos de espera son pseudoaleatorios, una distribución pseudoaleatoria obvio no corresponde al comportamiento real del tráfico en una red, por lo que los nodos pueden entrar en espera aún cuando realmente deben estar despiertos porque la red se los exige. Lo bueno es que este método se puede adaptar a las condiciones de cada red modificando las probabilidades y el número de semillas.

Sin embargo, los experimentos demuestran que el modelo propuesto es mejor a uno ya existente por lo que se puede decir que el experimento fue exitoso.

Como trabajo adicional se puede experimentar con los diferentes parámetros para establecer las probabilidades reales de preactivación que proporcionen resultados mejores en condiciones de congestión alta.

Referencias

An Energy-Efficient MAC Protocol with Random

Listen-Sleep Schedule for Wireless Sensor Networks

Sung-Chan Choi∗ , Jang-Won Lee∗ , Yeonsoo Kim† , Hakjin Chong†

∗ Dept. of Electrical and Electronic Engineering, Yonsei University, Seoul, Korea

† Future Technology Laboratory, KT, Seoul, Korea

** Imágenes tomadas del respectivo paper.